Torek, 30. 3. 2021, 16.19

4 leta, 6 mesecev

Resno svarilo FBI: Prihajajo sintetični ljudje, pazite, komu verjamete

Grožnja tehnologije deepfake, s katero je med drugim mogoče ustvarjati prepričljive replike resničnih oseb ali pa iz nič narediti nove ljudi, je očitno postala dovolj velika, da je uradno opozorilo pred kratkim izdal tudi ameriški zvezni preiskovalni urad FBI. Prepričani so, da bomo v prihodnjih od 12 do 18 mesecih doživeli poplavo tako imenovanih sintetičnih vsebin, katerih namena bosta predvsem manipuliranje z javnim mnenjem v politične namene in pa spletne goljufije.

Preiskovalni urad FBI med sintetične vsebine prišteva videoposnetke, fotografije, zvočne posnetke (in do določene mere besedilo), ki so bili predelani oziroma ustvarjeni tako, da ciljno občinstvo prepričajo o istovetnosti sporočila oziroma legitimnosti tistega, ki to sporočilo podaja.

Konkreten primer je lahko videoposnetek politika, ki laže o svojih preteklih dejanjih, obdelana fotografija, ki javno osebo prikazuje v slabi luči, sintetično ustvarjen posnetek telefonskega pogovora, ki razkriva domnevno kaznivo dejanje.

Gre za vsebine, ki jih je danes mogoče ustvariti računalniško, in to na tako visoki ravni, da večina ljudi ne bo znala razlikovati med njimi in resničnostjo oziroma brez ustreznega znanja ne bo prepoznala ponaredkov, opozarja FBI. Tehnologija, ki to omogoča, je na spletu prosto dostopna vsem, obenem pa s časom postaja vse bolj napredna, kar pomeni, da se kakovost sintetičnih vsebin izboljšuje.

Splošno uveljavljen izraz za računalniške ponaredke, pred katerimi svari FBI, je deepfake. Globoki ponaredek, če izraz poskusimo prevesti v slovenski jezik, temelji na umetni inteligenci oziroma na tako imenovanem strojnem učenju.

Gre za princip samoizobraževanja, pri katerem, če za primer uporabimo ponarejanje določene osebe, specializirani računalniški program analizira na desetine ali celo stotine ur videoposnetkov določene osebe, da bi razumel, kako se premika, govori, kako je videti pod različnimi koti in ob spremenljivi osvetlitvi.

Tehnologija deepfake je božji dar za manipulatorje in goljufe

Pri FBI pričakujejo, da se bo pojavljanje sintetičnih vsebin v prihodnjem letu oziroma v letu in pol okrepilo, uporabljene pa bodo predvsem za dva namena: manipuliranje z javnim mnenjem v politične namene in goljufije. Opozorili so, da že od leta 2019 odkrivajo politično motivirane kampanje, pri katerih osrednjo vlogo igrajo vse bolj prepričljivi ponaredki, in dodali, da njihovo število narašča.

Lani smo poročali o Oliverju Taylorju, študentu, blogerju in občasnem novinarju, ki ga je po razkritju tiskovne agencije Reuters nekdo ustvaril izključno za poskus diskreditacije palestinskega pravnika. Ta je bil v zadnjih letih trn v peti kontroverznemu izraelskemu podjetju NSO Group, ki razvija visokotehnološke rešitve za prisluškovanje in vdiranje v informacijske sisteme. Taylor je bil kot lažna oseba tako prepričljiv, da mu je prispevke uspelo objaviti v uglednih judovskih medijih The Jerusalem Post, Algemeiner Journal in The Times of Israel.

Lani smo poročali o Oliverju Taylorju, študentu, blogerju in občasnem novinarju, ki ga je po razkritju tiskovne agencije Reuters nekdo ustvaril izključno za poskus diskreditacije palestinskega pravnika. Ta je bil v zadnjih letih trn v peti kontroverznemu izraelskemu podjetju NSO Group, ki razvija visokotehnološke rešitve za prisluškovanje in vdiranje v informacijske sisteme. Taylor je bil kot lažna oseba tako prepričljiv, da mu je prispevke uspelo objaviti v uglednih judovskih medijih The Jerusalem Post, Algemeiner Journal in The Times of Israel.

Tako diskreditiranje političnih nasprotnikov kot kraja denarja z goljufijo, pri katerih je bila zlorabljena tehnologija deepfake, sta se že znašla na očeh javnosti.

Leta 2019 se je na spletu pojavil predelan videoposnetek Nancy Pelosi, predsednice predstavniškega doma ZDA. Njegov namen je bil gledalca prepričati, da je bila med javnim nagovorom pod vplivom alkohola, a se je kasneje izkazalo, da je šlo za deepfake. Videoposnetek je takrat na Twitterju delil tudi nekdanji predsednik ZDA Donald Trump.

Oglejte si deepfake posnetek Vladimirja Putina o vmešavanju v volitve v ZDA in političnem razkolu:

Istega leta se je v Veliki Britaniji zgodila najverjetneje precedenčna poslovna prevara, pri kateri je direktor podjetja verjel, da ga je poklical njegov šef, prvi mož starševskega podjetja iz Nemčije, in madžarskemu dobavitelju po navodilih šefa nakazal 220 tisoč evrov. Kasneje se je izkazalo, da je bil žrtev prevaranta, ki je s pomočjo umetne inteligence izdelal sintetični glas šefa.

Ali je sintetičnega človeka sploh mogoče ločiti od pravega?

Strokovnjaki za umetno inteligenco in informacijsko varnost že nekaj časa opozarjajo, da bo to vedno težje, saj se tehnologija strojnega učenja razvija izredno hitro, obenem pa za zdaj še ne obstajajo pravi pravni mehanizmi, s katerimi bi lahko zajezili oziroma nadzorovali njen napredek (poraja se seveda tudi vprašanje, ali bi bilo kaj takega sploh smotrno glede na koristi, ki jih strojno učenje prinaša na drugih področjih).

Da je ločevanje ponarejenih oseb od resničnih težko, je pred kratkim dokazala serija viralnih videoposnetkov hollywoodskega zvezdnika Toma Cruisa. Šlo je za deepfake posnetke, ki pa so bili tako prepričljivi, da je marsikdo verjel, da na njih res nastopa Cruise, kar so dokazovali tudi osupli odzivi uporabnikov na družbenih omrežjih.

FBI sicer svetuje, da se pri prepoznavanju domnevnih človeških replik ali pa v celoti računalniško ustvarjenih ljudi osredotočimo na razmik med očmi, če gledamo samo obraz, ter na usklajenost premikanja glave in trupa, če nas zanima istovetnost videoposnetka, na katerem je vidno celotno telo osebe.

Eden od pokazateljev, da gre najverjetneje za deepfake, je tudi obrazna mimika pri govoru, predvsem neusklajenost drugih obraznih potez s premikanjem ust.

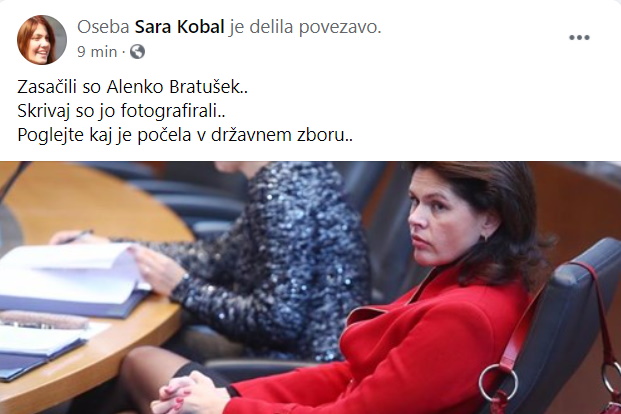

FBI opozarja tudi na previdnost pred uporabniki družbenih omrežij, ki uporabljajo ponarejene slike ljudi. Te lahko v zadnjem času zasledimo tudi na slovenskem Facebooku, kjer že nekaj mesecev poteka organizirana kampanja deljenja povezav do novic v različne skupine z več tisoč uporabniki. V njih namreč sodelujejo tudi profili s fotografijami, ki so jih najverjetneje pridobili na spletni strani za generiranje človeških obrazov. Kdo je v ozadju, ni znano, novice pa vodijo na spletne strani, ki uporabnika zasujejo z oglasi.

FBI opozarja tudi na previdnost pred uporabniki družbenih omrežij, ki uporabljajo ponarejene slike ljudi. Te lahko v zadnjem času zasledimo tudi na slovenskem Facebooku, kjer že nekaj mesecev poteka organizirana kampanja deljenja povezav do novic v različne skupine z več tisoč uporabniki. V njih namreč sodelujejo tudi profili s fotografijami, ki so jih najverjetneje pridobili na spletni strani za generiranje človeških obrazov. Kdo je v ozadju, ni znano, novice pa vodijo na spletne strani, ki uporabnika zasujejo z oglasi.

Preberite tudi:

10