Četrtek, 22. 2. 2018, 20.05

1 leto, 1 mesec

Deepfakes: lahko gole zvezdnice povzročijo težavo svetovnih razsežnosti?

Na spletnem forumu Reddit so se ob koncu leta 2017 pojavili filmi za odrasle, v katerih so obraze pornoigralk strašljivo prepričljivo zamenjali obrazi svetovno znanih filmskih zvezdnic. Ker stopajo onkraj meja etične in moralne sprejemljivosti, so se tako imenovani posnetki "deepfakes" praktično takoj znašli v nemilosti spletnih velikanov. Ti so jih prepovedali oziroma jih redno odstranjujejo, a seme je že zasajeno. Ali kmalu ne bomo več vedeli, kaj je res in kaj ne?

Kaj so "deepfakes" in kako so nastali

Decembra 2017 je tehnološki medij Motherboard prvič opozoril na kontroverzne vsebine na Redditu, z naskokom najbolj obiskanem spletnem forumu, ki jih je objavljal uporabnik z vzdevkom deepfakes. To so bili pornografski filmi, ki jih je deepfakes predelal tako, da so v njih nastopale zvezdnice svetovnega kova, kot so Gal Gadot (zgoraj), Emma Watson, Taylor Swift, Scarlett Johansson.

Na Redditu je sicer že prej dolgo živela skupnost CelebFakes, v kateri so uporabniki objavljali fotomontaže filmskih in glasbenih zvezdnic s pomanjkljivo garderobo in v kočljivih pozah. A česa takega, kar jim je ponudil uporabnik deepfakes, še niso videli.

Videoposnetki uporabnika deepfakes so bili zaradi izredno realistične obrazne mimike namreč tako prepričljivi, kot da so v njih res nastopila omenjena slavna dekleta. Igralka Daisy Ridley (na fotografiji), prvi obraz novih delov znanstvenofantastične serije Vojna zvezd, seveda ni nikoli nastopila v pornografskem filmu, a so uporabniki foruma Reddit to kar težko verjeli. | Foto: Reddit

Videoposnetki uporabnika deepfakes so bili zaradi izredno realistične obrazne mimike namreč tako prepričljivi, kot da so v njih res nastopila omenjena slavna dekleta. Igralka Daisy Ridley (na fotografiji), prvi obraz novih delov znanstvenofantastične serije Vojna zvezd, seveda ni nikoli nastopila v pornografskem filmu, a so uporabniki foruma Reddit to kar težko verjeli. | Foto: Reddit

Ta "zvrst" videoposnetkov je dobila ime kar po njihovem ustvarjalcu, torej deepfakes. Kot je v svojih objavah večkrat pojasnil uporabnik deepfakes, je te videoposnetke ustvarjal s pomočjo strojnega računalniškega učenja (tako imenovani deep learning - od tu ime deepfakes, fake v tem kontekstu pomeni ponaredek).

Strojno (računalniško) učenje je metoda, s katero računalniški program svojo veščino v opravljanju določene naloge izboljšuje samodejno na podlagi preteklih izkušenj: več kot se z njo ukvarja, bolje jo bo opravljal. Gre za enega od pomembnih gradnikov razvoja umetne inteligence.

Strojno (računalniško) učenje je metoda, s katero računalniški program svojo veščino v opravljanju določene naloge izboljšuje samodejno na podlagi preteklih izkušenj: več kot se z njo ukvarja, bolje jo bo opravljal. Gre za enega od pomembnih gradnikov razvoja umetne inteligence.

Čeprav bi zaradi prepričljivosti njegovih videoposnetkov kdo lahko posumil, da ima uporabnik deepfakes dostop do profesionalne filmske opreme za ustvarjanje posebnih učinkov, je na forumu Reddit večkrat pojasnil, da je računalniški program, s katerim je zamenjal obraze, napisal sam.

Pri tem so mu pomagala prosto dostopna brezplačna orodja za implementacijo strojnega učenja, kot sta Googlov TensorFlow in Keras. V svoj program je vstavil ciljni videoposnetek, mu povedal, kateri obraz naj zamenja, in ga povezal s knjižico fotografij izbrane filmske zvezdnice, ki jih je našel na spletu in na družbenih omrežjih. Program je po nekaj urah premlevanja podatkov ustvaril videoposnetek, ki ga je deepfakes nato delil s forumom Reddit.

Živimo v času, ko lahko vsak dela tisto, za kar Hollywood zapravlja milijone

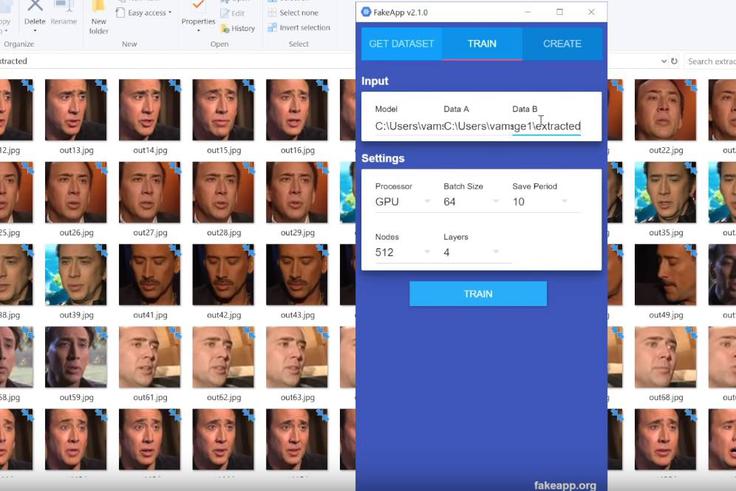

Po prvotnih objavah uporabnika deepfakes ni minilo veliko časa, ko je nekdo drug ustvaril orodje FakeApp, ki zamenjave obrazov več ne pogojuje s programerskim znanjem.

Vsak, ki ima 12 minut časa, da si ogleda videoposnetek z navodili, kako to početi, se lahko ustvarjanja svojih videoposnetkov z orodjem FakeApp loti sam. Razvijalec FakeApp uporabnike sicer poziva, naj orodja nikar ne zlorabljajo za ustvarjanje pornografskih videoposnetkov z obrazi oseb, ki v to niso privolile, a marsikateri uporabnik se na to požvižga.

Vsak, ki ima 12 minut časa, da si ogleda videoposnetek z navodili, kako to početi, se lahko ustvarjanja svojih videoposnetkov z orodjem FakeApp loti sam. Razvijalec FakeApp uporabnike sicer poziva, naj orodja nikar ne zlorabljajo za ustvarjanje pornografskih videoposnetkov z obrazi oseb, ki v to niso privolile, a marsikateri uporabnik se na to požvižga.

Kaj se je zgodilo? Nekateri uporabniki so takoj začeli obraze igralcev v znanih filmih zamenjevati z Nicolasom Cageem, ki je pogosto tarča internetnih šaljivcev:

A britje norcev iz Nicolasa Cagea je bilo kaplja v morje proti trendu, ki se je začel na forumu Reddit. "Deepfakes" je postal samostojen podforum, v katerega je na stotine uporabnikov začelo objavljati svoje "izdelke" - pornografske videoposnetke z znanimi igralkami -, na tisoče pa jih je ta forum začelo obiskovati.

Ko je vodstvo Reddita udarilo po mizi in izbrisalo celoten forum r/deepfakes ter za dobro mero še ponarejevalce pornografskih fotografij r/CelebFakes, se je novonastala skupnost "filmarjev", ki si pomagajo s strojnim učenjem, preselila drugam.

Spletni portali, namenjeni prav "zvrsti" deepfakes, se pojavljajo kot gobe po dežju, videoposnetki pa pogosto zaidejo tudi na najbolj obiskane spletne strani s pornografsko vsebino, kot je Pornhub, ta je takšne objave sicer že prepovedal in jih redno odstranjuje. K blokiranju tovrstnih vsebin je pristopil tudi Twitter.

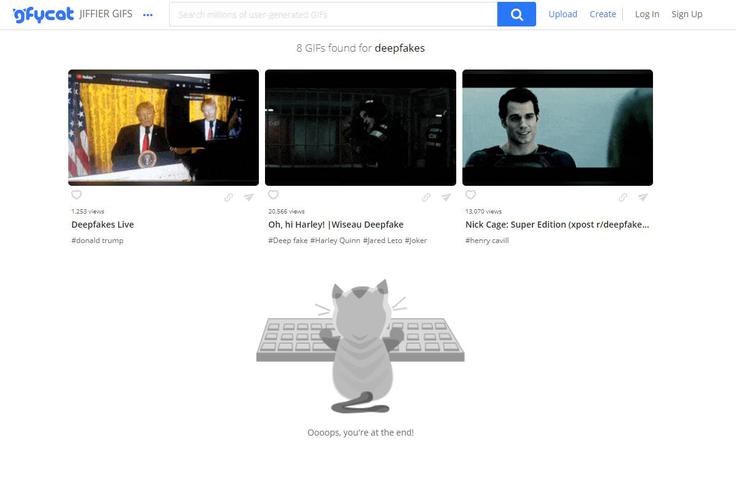

V boj proti deepfakes sta se vključila tudi Gfycat in Giphy, dva od največjih ponudnikov hrambe za animirane sličice (GIF). Gfycat je na misijo prepoznavanja in odstranjevanja sličic oziroma animacij, ki so nastale s pomočjo strojnega učenja in aplikacij, kot je FakeApp, poslal celo lastno umetno inteligenco, ki deluje tako kot njen plen - sproti se uči, kateri posnetki so sporni in jih je zato treba izbrisati. Za zdaj gre Gfycatu kar dobro, saj na spletni strani pod ključno besedo deepfakes praktično ni več mogoče najti neprimernih animacij.

V boj proti deepfakes sta se vključila tudi Gfycat in Giphy, dva od največjih ponudnikov hrambe za animirane sličice (GIF). Gfycat je na misijo prepoznavanja in odstranjevanja sličic oziroma animacij, ki so nastale s pomočjo strojnega učenja in aplikacij, kot je FakeApp, poslal celo lastno umetno inteligenco, ki deluje tako kot njen plen - sproti se uči, kateri posnetki so sporni in jih je zato treba izbrisati. Za zdaj gre Gfycatu kar dobro, saj na spletni strani pod ključno besedo deepfakes praktično ni več mogoče najti neprimernih animacij.

Ne le zvezdnice, pred montažami nismo varni niti "navadni" ljudje

Dostopnost in preprostost uporabe tehnologije, ki omogoča realistično zamenjavo obrazov, lahko v zadrego ne spravi le zvezdnic (in, sicer precej redkeje, zvezdnikov), temveč tudi "navadne" ljudi.

Na spletu namreč že obstajajo skupnosti, ki orodja, kot je FakeApp, uporabljajo za ustvarjanje pornografskih videoposnetkov, v katerih nastopajo njihove sošolke ali nekdanja dekleta. Njihove fotografije pridobijo na družbenih omrežjih, največkrat na Instagramu.

Takšne videoposnetke lahko ustvarjalci uporabijo ne le za lastno zabavo, temveč tudi za maščevanje ali izsiljevanje drugih oseb.

Maščevalna pornografija je moralno zelo sporna, a na spletu precej uveljavljena zvrst pornografije. Gre za intimne videposnetke, ki so nastali, ko sta bili dve osebi še v partnerski zvezi, ko pa sta se razšli, jih je ena od njiju, da bi se za zlomljeno srce ali kaj drugega maščevala drugi, objavila na spletu.

Maščevalna pornografija je moralno zelo sporna, a na spletu precej uveljavljena zvrst pornografije. Gre za intimne videposnetke, ki so nastali, ko sta bili dve osebi še v partnerski zvezi, ko pa sta se razšli, jih je ena od njiju, da bi se za zlomljeno srce ali kaj drugega maščevala drugi, objavila na spletu.

Strašljive implikacije za prihodnost

Težava za žrtve maščevalnih ali izsiljevalskih videoposnetkov, ki v njih sicer niso nikoli nastopile, temveč so nastali s pomočjo strojnega učenja, je, da živijo v obdobju, ko veliko problematiko predstavljajo lažne novice. Kako ljudje ne bodo verjeli intimnemu videoposnetku, ki je videti zelo resnično, ko pa jih je ogromno verjelo še precej bolj za lase privlečenim zgodbam?

Treba je sicer poudariti, da je premontaža obrazov v pornografskih videoposnetkih vrh ledene gore. Kaj šele bo, ko se bo nekdo resneje lotil ustvarjanja videoposnetkov, ki lahko povzročijo resno politično ali družbeno krizo?

Samo vprašanje časa je namreč, kdaj bodo na uporabniški ravni dostopne tehnologije, kot sta Adobe VoCo, ki lahko po nekaj minutah poslušanja (tudi zvočnih posnetkov) natančno posnema glas vsakega človeka, in Face2Face, ki omogoča prenos človeške obrazne mimike na animirane obraze vplivnih oseb, na primer predsednika ZDA Donalda Trumpa.

umetna inteligenca

umetna inteligenca

1