Torek, 5. 9. 2017, 5.08

1 leto

Koga naj povozi samovozeči avto?

Ena od treh temeljnih smernic raziskave se osredotoča na etiko samovozečih avtomobilov in na vprašanje, kako vzgojiti umetno inteligenco, da se bo v kritični situaciji za volanom odzvala etično.

V MIT Media Lab, enemu od prejemnikov sredstev za raziskavo etičnih vprašanj, so za raziskavo moralnega kompasa ustvarili Moral machine, spletno igro o moralnih odločitvah, ki čakajo inteligentne stroje kot so samovozeči avtomobili.

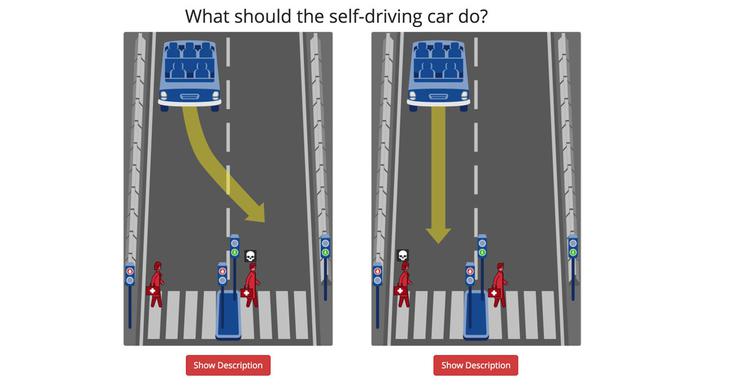

Moral machine igralce sooča z nizom hipotetičnih situacij, vse pa se dogajajo na cestišču pred prehodom za pešce, ko samovozečemu avtomobilu odpovedo zavore. Vprašanje je vselej isto: kaj naj v danem trenutku naredi samovozeči avto?

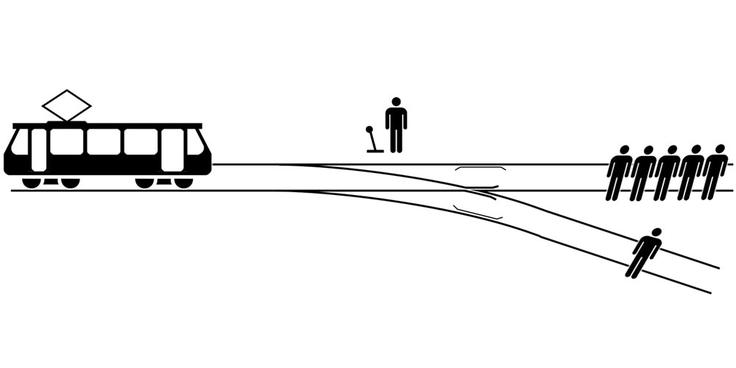

Igra temelji na etičnem vprašanju, ki ga je že leta 1969 zastavila filozofinja Philippa Foot na primeru okvarjenega trolejbusa: če bi imeli možnost preusmeriti pobegli trolejbus, čigavo življenje bi rešili? Bi se, na primer, raje odločili za smrt petih neznancev ali enega prijatelja?

A čeprav daje vtis, da gre etiko, se zdi smoter igre Moral machine sporen. Že res, da je pomembno razmisliti, kakšno umetno inteligenco želimo vzgojiti in kako naj ta ravna v kritičnih trenutkih, a temu razmisleku mora predhoditi še vprašanje metode. Je takšna igra res primerna za vzgojo umetne inteligence?

No, za zdravega belega moškega atletske postave v poslovni obleki bržkone ni strahu, pravica je že od nekdaj na njegovi strani, a kako je biti v koži marginalizirane barve, v manjvrednem spolu, hendikepiranemu telesu, ko ti sodi umetna inteligenca, ki se je naučila pristranskosti prav na osnovi vse bolj sovražnega javnega mnenja?

Le spomnimo se, kako hitro je svojo nedolžnost izgubila roboklepetulja Tay in kako pristranska je zavoljo diskriminatorne zgodovine umetna inteligenca, ki že pomaga pri ameriških sodnih procesih.

Hipotetičnim situacijam, ki jih ponazarja MIT, bi se bilo v veliki meri mogoče izogniti s povečanimi tehničnimi zahtevami za samovozeče avtomobile, na primer z dvojnim sistemom zavor, s povečanimi omejitvami hitrosti na tovrstnih križiščih in tako dalje.

In tudi če bi vse odpovedalo - čemu ne moremo sprejeti preprostega dejstva, da niti umetna inteligenca ne zmore vselej ukrepati tako, da prepreči nesrečo. Mar ne bi bilo bolje sprejeti dejstva, da se nesreče dogajajo tudi samovozečim avtomobilom, kot pa se pretvarjati, da smo moralni, ko presojamo, koga smemo ubiti, ker je manjvreden od drugih?

Tako težke misli olajša novica, ki je nedavno prišla iz Nemčije. Tamkajšnja vlada je konec avgusta naznanila smernice etične komisije glede samovozečih avtomobilov. Komisija je poudarila, da je v primeru neizogibnih nezgodnih situacij vsako razlikovanje med posamezniki, ki temelji na osebnih značilnostih (starost, spol, telesna ali duševna ustava) nedopustno, samovozeči avtomobili pa morajo biti programirani z razumevanjem, da je vsako človeško življenje enakovredno drugemu.

Članek je bil prvotno objavljen na Telekomovem Tehniku.

umetna inteligenca

umetna inteligenca